Jei norite savo kompiuteryje paleisti Large Language Models arba LLM, vienas iš paprasčiausių būdų tai padaryti yra per Ollama. „Ollama“ yra galinga atvirojo kodo platforma, siūlanti pritaikomą ir lengvai pasiekiamą AI patirtį. Tai leidžia lengvai atsisiųsti, įdiegti ir bendrauti su įvairiais LLM, nereikia pasikliauti debesimis pagrįstomis platformomis ar nereikalaujant jokių techninių žinių.

Be pirmiau minėtų pranašumų, „Ollama“ yra gana lengvas ir reguliariai atnaujinamas, todėl jis puikiai tinka kurti ir valdyti LLM vietinėse mašinose. Taigi, jums nereikia jokių išorinių serverių ar sudėtingų konfigūracijų. „Ollama“ taip pat palaiko kelias operacines sistemas, įskaitant „Windows“, „Linux“ ir „MacOS“, taip pat įvairias „Docker“ aplinkas.

Atsisiųskite ir įdiekite „Ollama“.

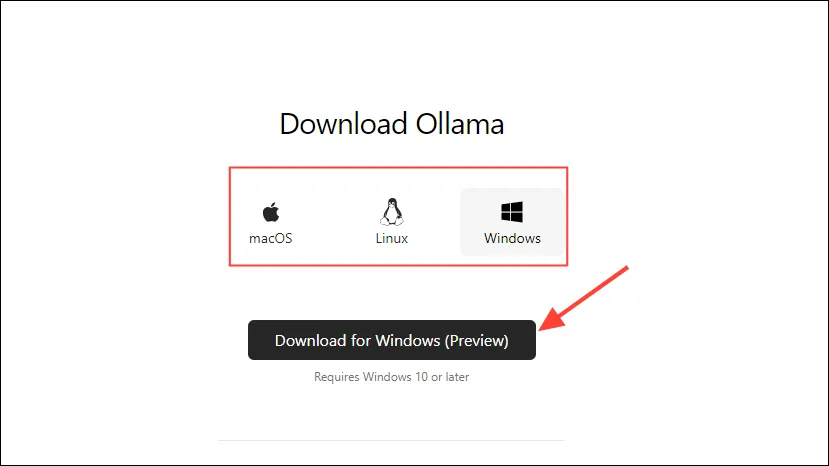

- Pirmiausia apsilankykite „Ollama“ atsisiuntimo puslapyje ir pasirinkite savo OS prieš spustelėdami mygtuką „Atsisiųsti“.

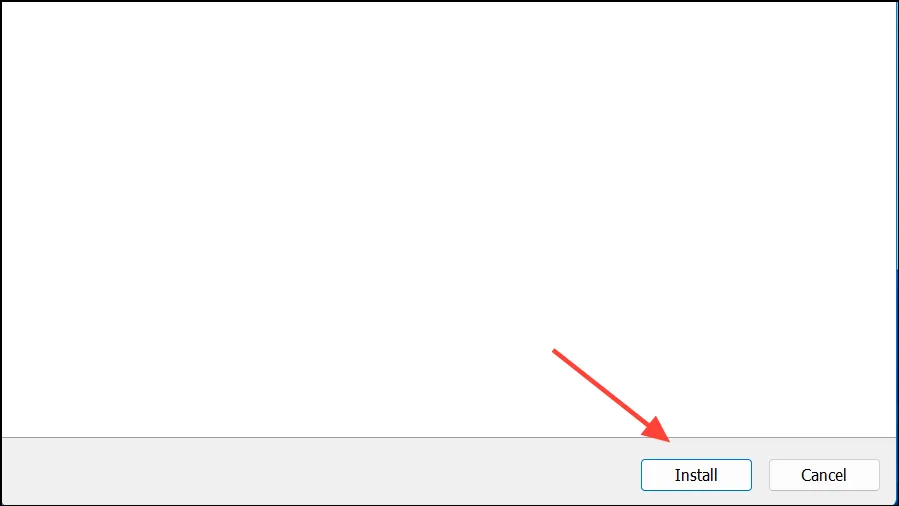

- Kai atsisiuntimas bus baigtas, atidarykite jį ir įdiekite jį savo kompiuteryje. Diegimo programa automatiškai užsidarys, kai diegimas bus baigtas.

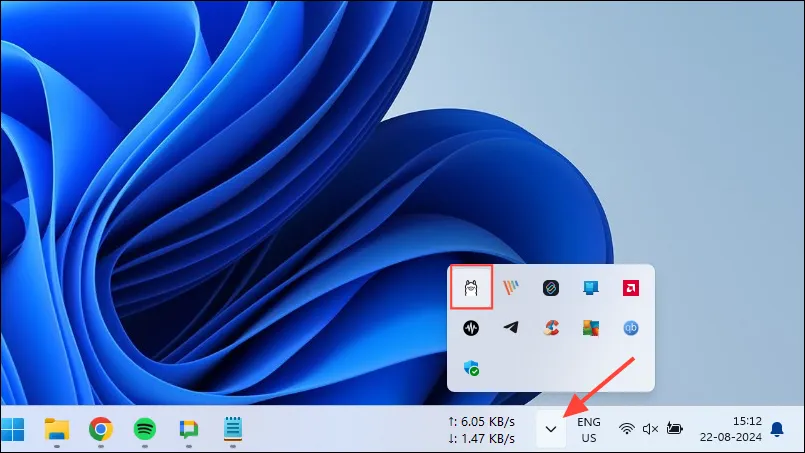

- „Windows“ sistemoje galite patikrinti, ar „Ollama“ veikia, ar ne, spustelėdami užduočių juostos perpildymo mygtuką, kad peržiūrėtumėte paslėptas piktogramas.

„Ollama“ pritaikymas ir naudojimas

Kai „Ollama“ bus įdiegta jūsų kompiuteryje, pirmiausia turėtumėte pakeisti duomenų saugojimo vietą. Pagal numatytuosius nustatymus saugojimo vieta yra, C:\Users\%username%\.ollama\modelsbet kadangi AI modeliai gali būti gana dideli, jūsų C diskas gali būti greitai užpildytas. Norėdami tai padaryti,

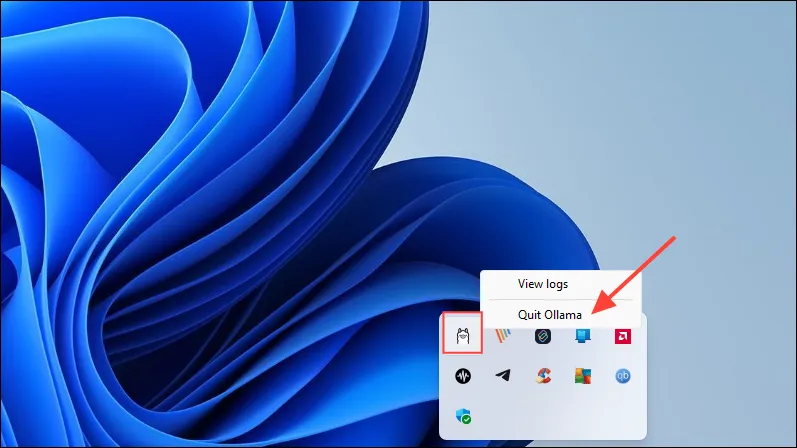

- Pirmiausia užduočių juostoje spustelėkite „Ollama“ piktogramą ir spustelėkite „Išeiti iš Ollamos“.

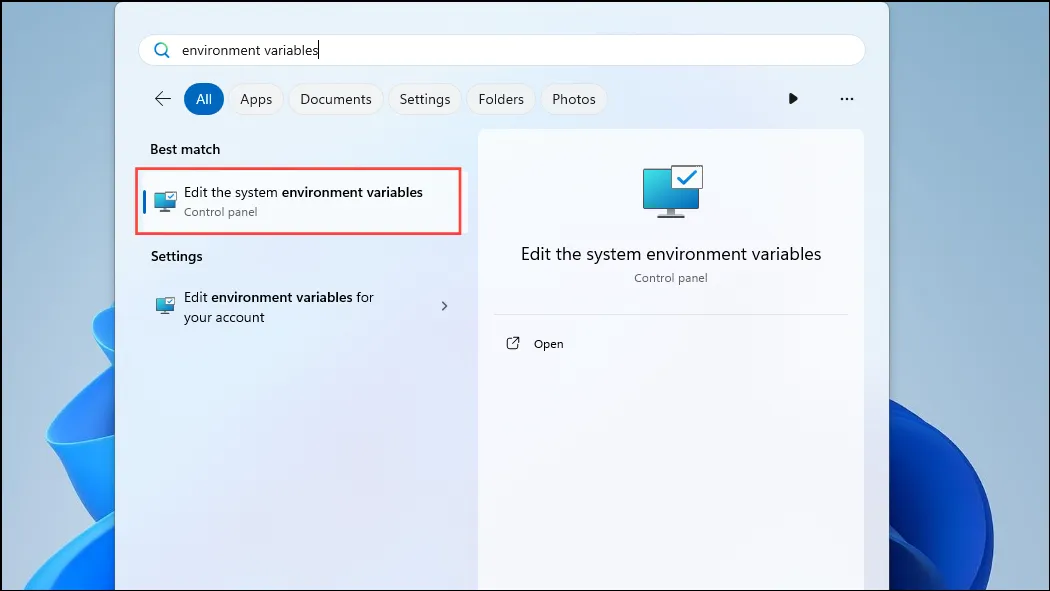

- Kai „Ollama“ išeina, atidarykite meniu Pradėti, įveskite

environment variablesir spustelėkite „Redaguoti sistemos aplinkos kintamuosius“.

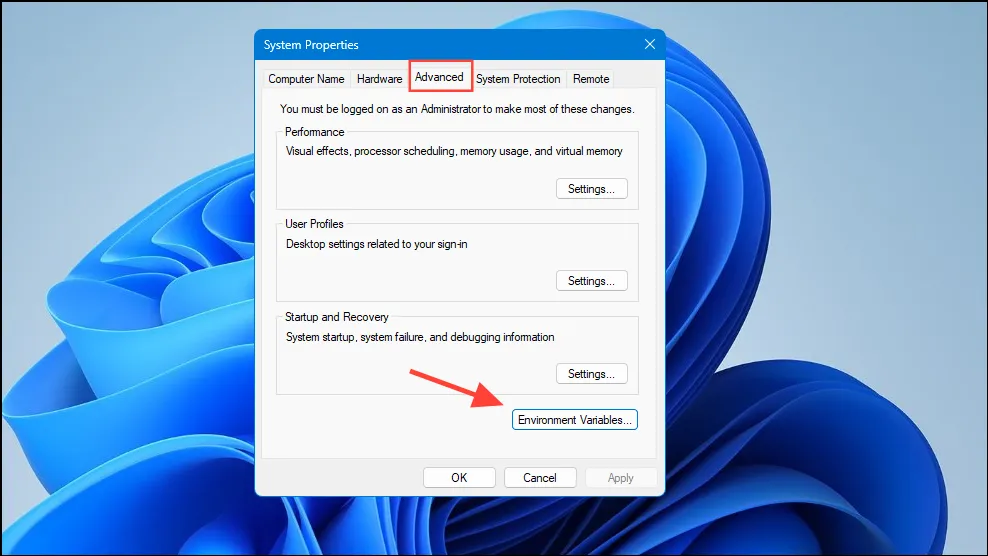

- Atsidarius dialogo langui Sistemos kintamieji, spustelėkite mygtuką „Aplinkos kintamieji“, esantį skirtuke „Išplėstinė“.

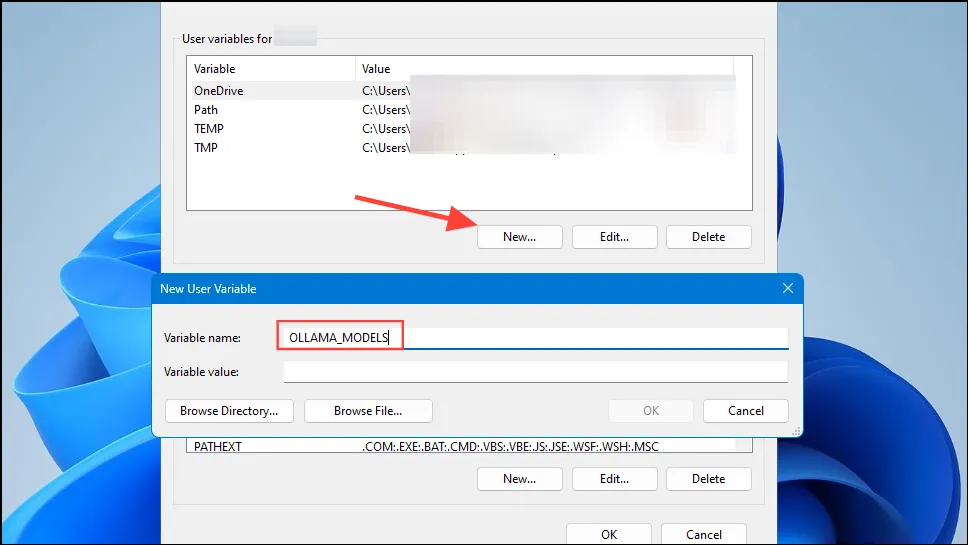

- Spustelėkite savo vartotojo abonemento mygtuką „Naujas“ ir

OLLAMA_MODELSlauke „Kintamojo pavadinimas“ sukurkite kintamąjį.

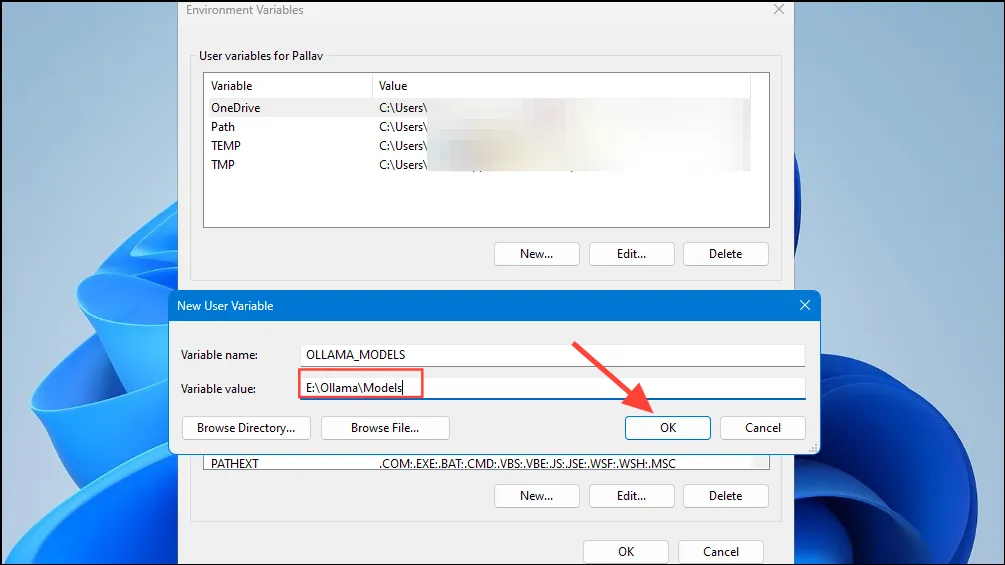

- Tada lauke „Kintamoji vertė“ įveskite katalogo, kuriame norite, kad „Ollama“ saugotų savo modelius, vietą. Tada spustelėkite mygtuką „Gerai“, prieš paleisdami „Ollama“ iš meniu Pradėti.

- Dabar esate pasirengę pradėti naudoti „Ollama“ ir tai galite padaryti naudodami „Meta’s Llama 3 8B“ – naujausią bendrovės atvirojo kodo AI modelį. Norėdami paleisti modelį, meniu Pradėti paleiskite komandų eilutę, Powershell arba Windows terminalo langą.

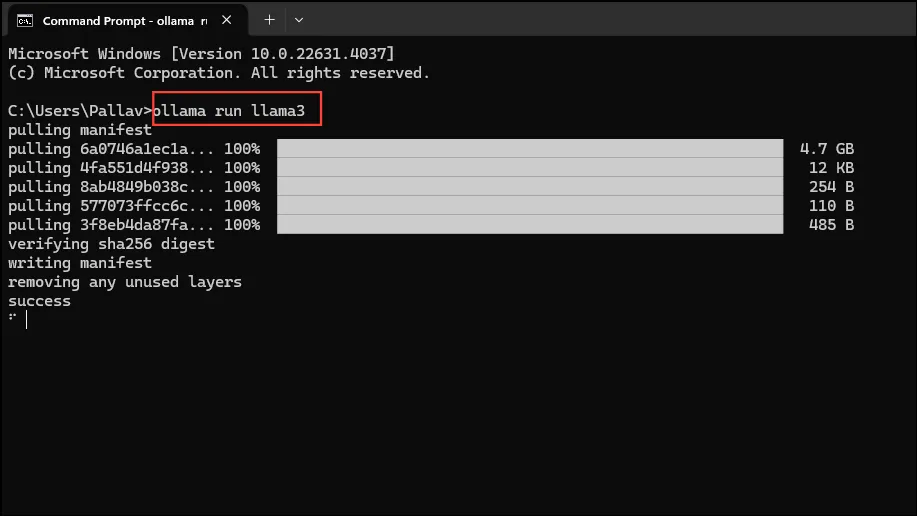

- Kai atsidarys komandų eilutės langas, įveskite

ollama run llama3ir paspauskite Enter. Modelis yra beveik 5 GB, todėl jo atsisiuntimas užtruks.

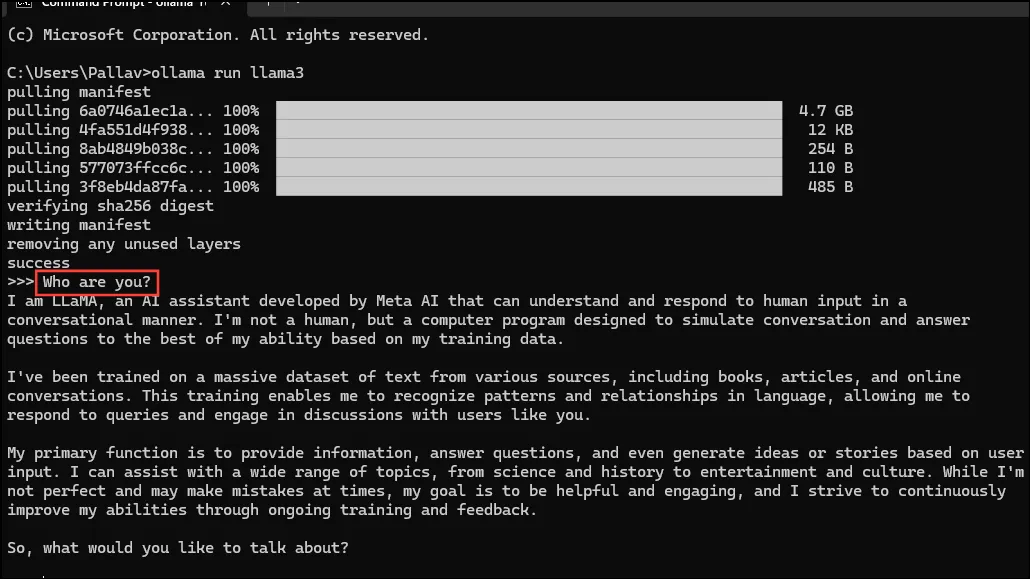

- Kai atsisiuntimas bus baigtas, galėsite pradėti naudoti „Llama 3 8B“ ir kalbėtis su juo tiesiogiai komandų eilutės lange. Pavyzdžiui, galite paklausti modelio

Who are you?ir paspausti Enter, kad gautumėte atsakymą.

- Dabar galite tęsti pokalbį ir užduoti AI modeliams klausimų įvairiomis temomis. Tiesiog atminkite, kad „Llama 3“ gali klysti ir haliucinuoti, todėl naudokite jį atsargiai.

- Taip pat galite išbandyti kitus modelius apsilankę Ollama modelių bibliotekos puslapyje. Be to, yra įvairių komandų, kurias galite paleisti ir išbandyti įvairias „Ollama“ siūlomas funkcijas.

- Taip pat galite atlikti įvairias operacijas paleisdami modelį, pvz., nustatyti seanso kintamuosius, rodyti modelio informaciją, išsaugoti seansą ir kt.

- „Ollama“ taip pat leidžia pasinaudoti multimodaliniais AI modeliais vaizdams atpažinti. Pavyzdžiui, LLava modelis gali atpažinti DALLE-3 sukurtus vaizdus. Jis gali išsamiai aprašyti vaizdus.

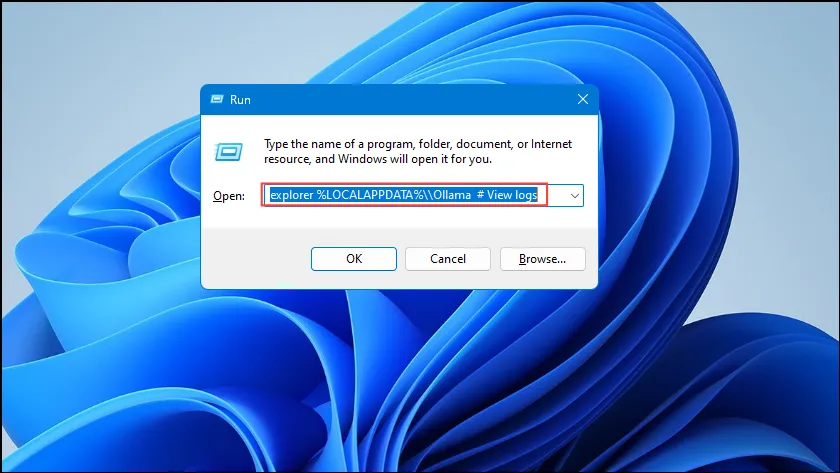

- Jei paleidžiant „Ollama“ atsiranda klaidų, galite patikrinti žurnalus, kad išsiaiškintumėte, kokia yra problema. Naudokite

Win + Rspartųjį klavišą, kad atidarytumėte dialogo langą Vykdyti, tada įveskiteexplorer %LOCALAPPDATA%\\Ollama # View logsjame prieš paspausdami Enter.

- Taip pat galite naudoti kitas komandas, pvz.,

explorer %LOCALAPPDATA%\\Programs\\Ollamair,explorer %HOMEPATH%\\.ollamanorėdami patikrinti dvejetainius failus, modelį ir konfigūracijos saugojimo vietą.

Ką reikia žinoti

- „Ollama“ automatiškai aptinka jūsų GPU, kad paleistų AI modelius, tačiau įrenginiuose su keliais GPU ji gali pasirinkti netinkamą. Norėdami to išvengti, atidarykite „Nvidia“ valdymo skydelį ir nustatykite ekraną į „Tik Nvidia GPU“.

- Ekrano režimas gali būti pasiekiamas ne kiekviename įrenginyje ir jo taip pat nėra, kai prijungiate kompiuterį prie išorinių ekranų.

- „Windows“ sistemoje galite patikrinti, ar „Ollama“ naudoja tinkamą GPU, naudodami užduočių tvarkytuvę, kuri parodys GPU naudojimą ir praneš, kuris iš jų naudojamas.

- Nors „Ollama“ diegimas sistemoje „MacOS“ ir „Linux“ šiek tiek skiriasi nuo „Windows“, LLM paleidimo per jį procesas yra gana panašus.

Parašykite komentarą